Cf. entradas anteriores de la serie:

- Resumen/Abstract;

- Capítulo 1: Introducción;

- Capítulo 2: Justificación y motivación;

- Capítulo 3: Objetivos;

- Capítulo 4: Planteamiento;

- Capítulo 5: Metodología;

- Capítulo 6: Gestión del conocimiento en las organizaciones;

- Capítulo 7: Indicadores del desempeño sostenible de las organizaciones;

- Capítulo 8: La gestión del conocimiento en el desempeño sostenible de las organizaciones.

Capítulo 8.1. Análisis de caso 1: captura, almacenamiento, estructuración y utilización de datos masivos de concentración de CO2 en un recinto cerrado.

El dióxido de carbono (CO2) es un gas presente en la atmósfera de forma natural en una concentración de, aproximadamente, 300 a 400 ppm (“The Keeling Curve,” 2016) . Además de ser el gas de efecto invernadero referente a la hora de medir el cambio climático global, es uno de los gases a los que más atención se les presta desde el punto de vista de la seguridad y salud laboral por su impacto en la salud humana:

- En concentraciones de 350 a 1000 ppm en un recinto cerrado, la calidad del aire se considera aceptable;

- En concentraciones de 1000 a 2000 ppm, la calidad del aire es considerada baja;

- Concentraciones de 2000 ppm a 5000 empiezan a causar problemas (dolor de cabeza, insomnio, náuseas). Es aire viciado;

- Concentraciones a partir de 5000 ppm, alteran la presencia de otros gases presentes en el aire, creándose una atmósfera tóxica o deficiente en oxígeno de consecuencias fatales según incrementa la concentración.

Por esta doble dimensión medioambiental (global) y de salud laboral (y personal) y por el significativo impacto de su concentración, el dióxido de carbono resulta un adecuado elemento para un análisis de caso.

La estación meteorológica NetAtmo es un sistema electrónico de consumo, basado en el concepto big data, que consta de varios sensores capaces de medir (“Netatmo Weather Station Specifications,” 2016) :

- Temperatura ambiente en un rango de -40 a 65°C, con un margen de error de +/- 0.3°C;

- Humedad de 0 al 100% con un margen de error de +/-3%;

- Presión atmosférica en un rango de 260 hasta 1160 mbar, con un margen de error de +-1 mbar;

- CO2 presente en el ambiente en un rango desde 0 hasta 5000 ppm (partes por millón) con un margen de error de +/- 50 ppm (partes por millón) o +/-5%;

- Ruido ambiental en un rango de 35 dB hasta 110 dB;

- Índice de calidad del aire en la atmósfera teniendo en cuenta los contaminantes más determinantes: partículas (PM10 y PM2.5), dióxido de nitrógeno (NO2), ozono (o3), monóxido de carbono (CO) y dióxido de azufre (SO2). Estos datos no son medidos por la propia estación, si no que son los que recibe del proyecto europeo CITEAIR (Información Común sobre el Aire en Europa).

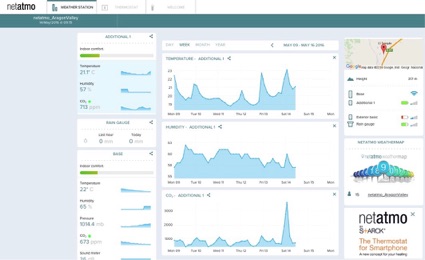

La interacción con la estación NetAtmo se realiza a través de un interface que proporciona la visualización remota y en tiempo real de la lectura de los sensores. La figura 3, muestra la apariencia de la interface en su versión para ordenador (En el anexo 11.2 de este Trabajo, se incluyen la figura a mayor tamaño, para una mejor visualización).

MicroStrategy es una plataforma basada en business inteligente y análisis predictivo, para la búsqueda, captura, almacenamiento, compartición y utilización de grandes cantidades de datos, i.e. big data (“ Analytics Platform Capabilities | MicroStrategy ,” 2016) .

El caso consistió en la captura, almacenamiento y análisis con la plataforma MicroStrategy Desktop 10.3, de los datos procedentes de la estación NetAtmo instalada en un domicilio—centro de trabajo (oficina) en la localidad de Ontinar de Salz, Zaragoza, con el siguiente alcance:

- El rango de datos abarca un año: desde el 1 de abril de 2015 al 31 marzo de 2016, agrupados por trimestres;

- Los atributos incluidos fueron: hora, día (fecha), día de la semana y mes de las mediciones;

- Las métricas incluidas fueron: concentración de CO2 en partes por millón (ppm), concentración de CO2 en partes por millón redondeada a múltiplos de 50 ppm, temperatura en ºC, humedad relativa en %;

- En total, se capturó un set datos con 857.452 valores.

La siguiente figura 4 esquematiza el proceso seguido, que queda explicado en detalle a continuación de la figura:

- Extracción de datos en formato base de datos Excel, con el rango y alcance establecidos, desde el panel de control de la interface de la estación NetAtmo hasta el ordenador local. El set de datos extraído alcanzó los 857.452 valores;

- Una vez en el ordenador local el set de datos en formato Excel, se procedió a la estructuración de la información, utilizando para ello un programa de hoja de cálculo (Numbers). La información se estructuró en cuatro atributos (hora, día—fecha, día de la semana y mes de las mediciones) y cuatro métricas (concentración de CO2 en partes por millón (ppm), concentración de CO2 en partes por millón redondeada a múltiplos de 50 ppm, temperatura en ºC, humedad relativa en %);

- Una vez almacenada localmente y estructurada la información, se realizó la captura del set de datos con la plataforma MicroStrategy Desktop;

- Con la información capturada se realizaron diferentes pruebas y análisis, hasta llegar a los resultados mostrados a continuación. Las siguientes figuras muestran alguno de los resultados significativos obtenidos.

Fue un proceso iterativo. Es decir, que en determinadas fases avanzadas fue necesaria una revisión de la información desde etapas anteriores. Esto mayormente ocurrió en la fase de pruebas y análisis, cuya efectividad y eficiencia se mejoró mediante reiteradas modificaciones en el set de datos en el nivel de estructuración e incluso nuevas extracciones de datos en origen.

En los anexos 11.3 y 11.4 de este Trabajo, se incluyen sendas figuras con la vista en modo panel de control de MicroStrategy a mayor tamaño, para una mejor visualización.

La figura 5 muestra representaciones en formato “heat map” de las siguientes métricas agrupadas bajo el atributo “hora”, separadas por trimestres:

- Concentración de CO2 redondeada a múltiplos de 50 ppm, representada por el tamaño de cada fractal;

- Temperatura media en ºC, representada por el color (verde-rojo) y la intensidad de cada fractal.

Un primer análisis de la figura permite observar que la concentración de CO2 y la hora del día tienen cierta correlación, al menos en el 1er trimestre de 2016, y el 2º y 4º de 2015. Esta correlación indica que las mayores concentraciones de CO2 se producen en las horas finales de cada día, sin embargo, con esta representación tipo “heat map” resulta complicado precisar la correlación.

Para precisar dicha correlación, resulta más apropiado el uso de otro tipo de representación, como la que se muestra en la figura 6, una tabla combinada en la que se muestran, separadas por trimestres:

- La concentración de CO2 redondeada a múltiplos de 50 ppm se representa con barras verticales;

- La temperatura media en ºC se representa con una línea también en el eje vertical, y con código de colores verde-rojo;

- La distribución horaria, en el eje horizontal.

La representación de los datos en esta tabla combinada permite observar mejor la correlación entre la concentración de CO2 y la hora del día. Pero, además, permite observar que la concentración de CO2 tiene también una correlación con la temperatura: a más temperatura, más concentración.

Aunque esta última circunstancia puede deberse en cierta medida a las propias características del dióxido de carbono, lo importante es que la representación permite precisar dicha correlación, que podrá (o no) deberse a otros factores ambientales además de al propio comportamiento del gas.

Este análisis de caso es muy ejemplificador del valor añadido que las tecnologías del conocimiento pueden incorporar a la información de aspectos relacionados con la sostenibilidad de una empresa.

En el caso concreto analizado, a pesar de que el número de atributos y métricas es limitado, se han logrado observaciones difícilmente accesibles de no haber contado con la combinación de los dos sistemas utilizados: la estación NetAtmo y la plataforma MicroStrategy. Por ejemplo, sólo teniendo en cuenta la correlación observada entre la concentración de CO2 con la hora del día en determinadas estaciones del año y la temperatura, se puede intervenir con mucha más eficacia sobre aspectos como la ventilación del recinto, la planificación de horarios de estancia o la climatización teniendo, en consecuencia, influencia en el consumo eficiente de energía y otros recursos.

Otro aspecto a tener en cuenta es el volumen de datos con los que se ha trabajado. Como se menciona al principio de este caso, el set de datos es de más de 857.000 registros, lo cual supone una muestra significativa que proporciona un fuerte soporte a una de las aplicaciones más pujantes dentro de las tecnologías del conocimiento: los análisis predictivos (Siegel, 2016) . Por ejemplo, en el caso concreto analizado, resulta altamente probable que, si no se ha intervenido sobre factores como la temperatura, climatización o utilización del recinto en el que se han realizado las mediciones, las concentraciones de CO2 en sucesivos años sigan el patrón marcado en los trimestres analizados.

Sin embargo, esta es sólo una muestra diferencial, a nivel casi de uso doméstico, del potencial de este tipo de tecnologías. En un caso hipotético pero perfectamente posible, en el que una empresa tiene a disposición muchos otros atributos y métricas como pueden ser ratios de productividad, incidentes, consumo energético de las instalaciones de climatización, etcétera, se pueden imaginar muchos más análisis, correlaciones, predicciones, etc., que den soporte a la toma de decisiones estratégicas para la organización. Un análisis más amplio de este tipo de tecnologías se realiza en el análisis de caso del apartado 8.5.

Por último, conviene mencionar también el excelente funcionamiento durante la realización del caso por la plataforma MicroStrategy en comparación con herramientas tecnológicas más tradicionales como son las hojas de cálculo (Excel y Numbers). Esto se ha podido observar especialmente durante la fase proceso de captura y estructuración de los datos: el rendimiento del ordenador disminuía significativamente mientras se usaban las hojas de cálculo, a pesar de que los datos con los que trabajaban eran datos brutos; sin embargo, el rendimiento del ordenador cuando los datos se importaron a la plataforma MicroStrategy apenas se veía afectado, a pesar de la mayor complejidad de las operaciones efectuadas (gráficos, cálculos, visualizaciones,…).

Aragonese

Aragonese English

English Spanish

Spanish